Test GeForce GTX Titan - Nieziemska wydajność, kosmiczna cena

- SPIS TREŚCI -

- 0 - Silni, zwarci i gotowi na przybycie tytana?

- 1 - NVIDIA GeForce GTX Titan - Budowa

- 2 - NVIDIA Kepler - Opis architektury #1

- 3 - NVIDIA Kepler - Opis architektury #2

- 4 - Platforma testowa i metodologia pomiarowa

- 5 - Testy: 3DMark 11

- 6 - Testy: Heaven Benchmark

- 7 - Testy: Stone Giant

- 8 - Testy: Aliens vs Predator

- 9 - Testy: Battlefield 3

- 10 - Testy: Crysis: Warhead

- 11 - Testy: Crysis 2

- 12 - Testy: DiRT 3

- 13 - Testy: Mafia II

- 14 - Testy: Metro 2033

- 15 - Testy: Stalker: Call of Pripyat

- 16 - Testy: The Elder Scrolls V: Skyrim

- 17 - Testy: Wiedźmin 2: Zabójcy Królów

- 18 - Testy: Hitman: Absolution

- 19 - Testy: Far Cry 3

- 20 - Testy: 5760x1080

- 21 - Podkręcanie: 3DMark 11 / Crysis 2 / Skyrim / AvP / Battlefield 3 / Wiedźmin 2

- 22 - Temperatury i system chłodzenia

- 23 - Pobór mocy: spoczynek / obciążenie / OC

- 24 - Podsumowanie: komu GTX Titan przypadnie do gustu?

Nowy silnik ekranowy

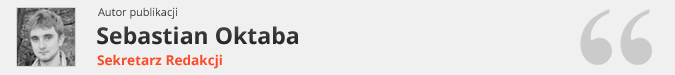

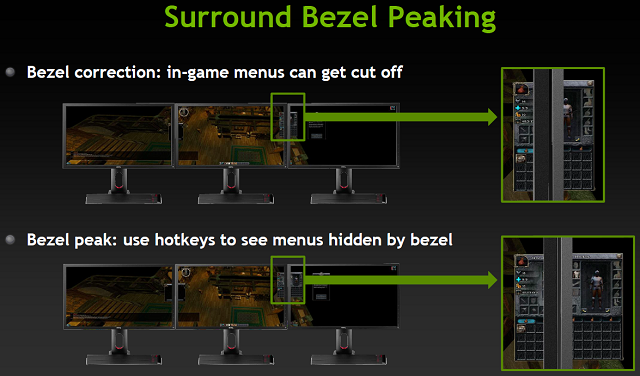

Nowa architektura to nie jedyna nowość wprowadzona przez NVIDIA wraz z Keplerem, bowiem „Zieloni” podobnie jak konkurencja przygotowała szereg nowinek technologicznych. Na tle poprzednich GeForców (z wyłączeniem "eksperymentów" Galaxy MDM) najbardziej innowacyjną naszym zdaniem zmianą jest poprawiony silnik odpowiedzialny za obsługę monitorów. W końcu będziemy mogli pracować na więcej niż dwóch ekranach czy nareszcie zagrać w ulubione tytuły wykorzystując NVIDIA Surround jak i NVIDIA 3D Surround na trzech ekranach, a wszystko to dzięki jednej karcie graficznej. Limit ekranów obsługiwanych przez urządzenie jest odrobinę mniej imponujący niż AMD, ponieważ Kepler pozwala na pracę na "tylko" 4 ekranach. Nie oszukujmy się jednak: liczba gier, które bez problemów będą działać na maksymalnych detalach w maksymalnej dostępnej rozdzielczości przy pięciu i więcej wyświetlaczach na HD 7970, jest raczej niewielka, a będą to prostsze oraz mniej wymagające tytuły. W takim świetle 3 ekrany w Surround z jednym dodatkowym np. do wyświetlenia czatu czy poradnika na stronie internetowej jest przyzwoitą ilością, zwłaszcza ponad dwa dotychczas obsługiwane ekrany w GeForce.

Oczywiście na tym zmiany w silniku ekranowym się nie kończą. Mamy pełne wsparcie dla nowej-generacji ekranów 4k, HDMI wspiera 3GHz, no i mamy też DisplayPort którego raczej ciężko odnaleźć na poprzednikach. NVIDIA Surround pozwala na grę przy 3 ekranach podłączonych do dowolnych portów - nie wymaga więc jak AMD aktywnej przejściówki DP na inny standard, czy po prostu monitora z portem DP. Możemy bez problemu uruchomić nietypową rozdzielczość 5760x1080 na trzech ekranach 1920x1200, co na Eyefinity na beta sterownikach dostarczonych z kartami 7800 było niemożliwe. Ponadto na Surround pasek Windowsa domyślnie znajduję się na środkowym monitorze, a maksymalizacja aplikacji odbywa się w obrębie aktualnego monitora, a nie całego rozciągniętego wirtualnego pulpitu, w czym NVIDIA także spisuje się lepiej od AMD. Dodać należy obsługę standardu wielo-strumieniowego audio i otrzymamy pełen obraz nowego silnika ekranowego.

GeForce GTX Titan - GPU Boost 2.0

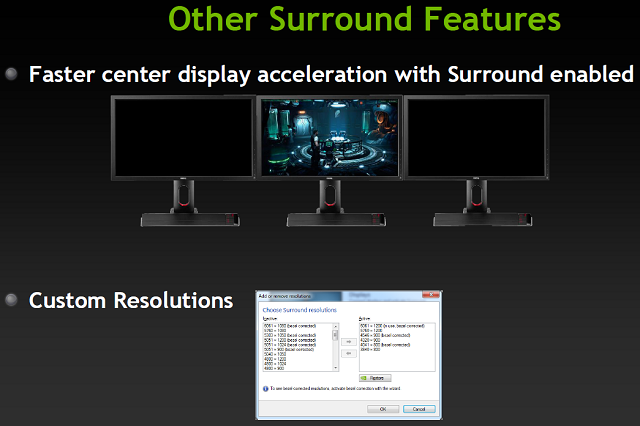

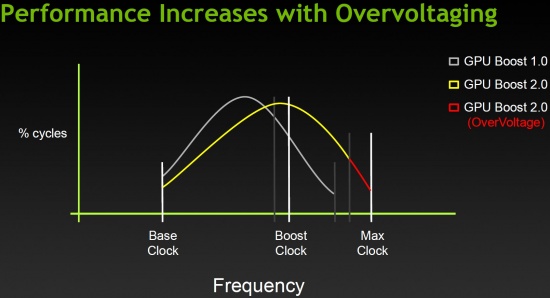

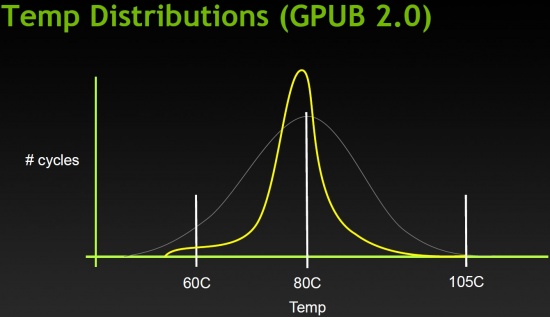

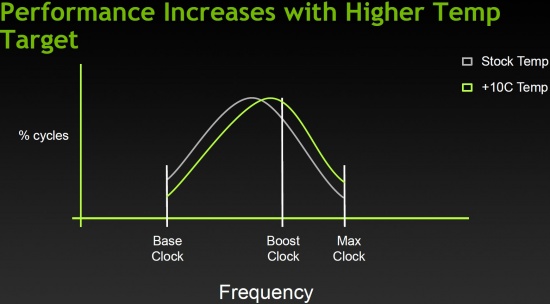

Wraz z GeForce GTX Titan, NVIDIA wprowadza technologię GPU Boost 2.0, która automatycznie zwiększa taktowanie rdzenia, dynamicznie dostosowując częstotliwości i napięcia. Inżynierowie NVIDI stwierdzili, że ograniczenie taktowania wynikające wyłącznie z limitu TDP do 170W jest zbyteczne, jeśli temperatura układu pozwala na dalsze zwiększanie zegara. Dlatego w GPU Boost 2.0 ustalono limit temperatury na 80 stopni Celsjusza, jako wyznacznik możliwości podnoszenia częstotliwości rdzenia. Karta stale monitoruje GPU i reguluje jego napięcie w locie, aby utrzymać bezpieczny poziom oraz kompromis między wzrostem wydajności i temperaturą. Zaawansowanym użytkownikom udostępniono możliwość zmiany tego progu z 80 do 85 stopni Celsjusza, co pozwala osiągnąć wyższe zegary. Rozwiązanie ma również pomóc w utrzymaniu niższego poziomu hałasu, zaś najwięcej skorzystają na tym właściciele chłodzenia wodnego, które będzie w stanie skuteczniej schłodzić GK110. Słowem - im niższa temperatura, tym wyższe zegary można osiągnąć. Mimo wszytko limit TDP istnieje, ale wynosi 250W z opcją zmiany do 265W. W GeForce GTX Titan wprowadzono też regulację napięcia rdzenia, którą można włączyć w zaawansowanych ustawieniach.

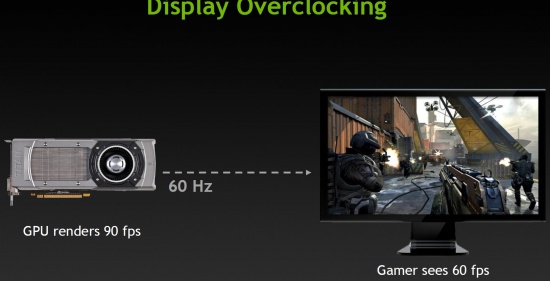

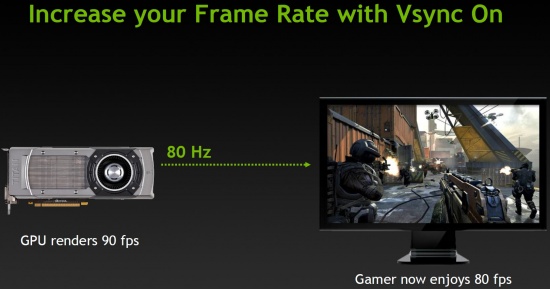

GeForce GTX Titan - Display Overclocking

GeForce GTX Titan wprowadza też pewne zmiany w synchronizacji pionowej, pozwalając podnieść standardową wartość z 60 do 75-80 Hz (tzw.: Display Overclocking). W sytuacji, gdy karta generuje taką ilość klatek na sekundę, zaś monitor wyświetla tylko 60 klatek, taki bajer może okazać się przydatny dla niektórych użytkowników. Rozwiązanie nie jest wprawdzie niczym nowym, ale mniej zaawansowanym i zorientowanym na podobne „tweaki” graczom, pomoże w dostosowaniu parametrów obrazu. Oczywiście, nie wszystkie monitory pozwalają na skorzystanie z takiej opcji, więc traktujemy to w kategorii ciekawostki.

Adaptacyjna synchronizacja - Adaptive Vsync

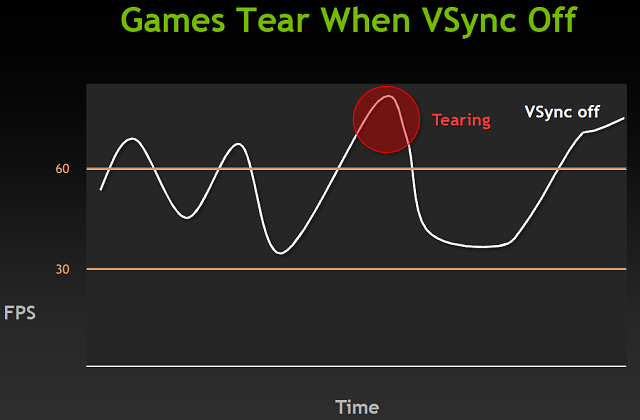

Podczas grania w gry nasza karta stara się domyślnie generować jak najwięcej klatek na sekundę. Następnie wysyła te klatki do monitora, a ten je wyświetla. Pojawia się jednak problem - monitory odświeżają obraz ze stałą predefiniowaną częstotliwością. Jeśli otrzymają dwie różne klatki w czasie odświeżania to naszym oczom ukażą się części obu tych klatek. Dokładniej górna część starszej i dolna część nowszej klatki. Powoduje to bardzo nieprzyjemny i bardzo dobrze widoczny efekt na ekranie przy szybko zmienianych scenach, zwłaszcza przy np. obracaniu widoku/kamery w poziomie. Nazywa się go Tearingiem (Poszarpaniem) - rozwiązaniem tej dolegliwości jest synchronizacja pionowa. Powoduje ona, że karta z wygenerowaniem nowej klatki czeka na monitor, a dokładniej jego proces odświeżania.

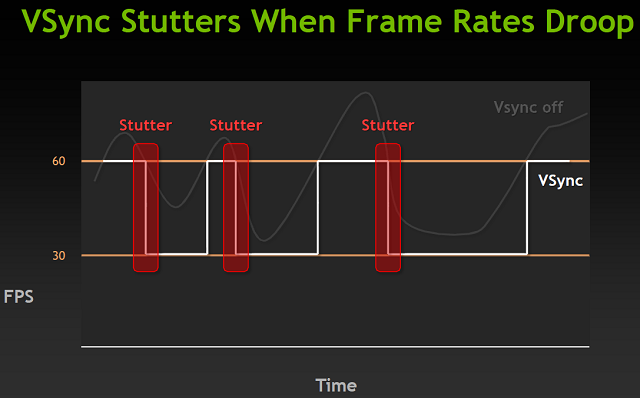

Typowy monitor LCD posiada odświeżanie pionowe z częstotliwością 60Hz, a jeśli nasza karta graficzna jest w stanie renderować ponad 60 klatek na sekundę, to problemu nie ma - karta ogranicza generowany FPS do 60 i synchronicznie z odświeżaniem ekranu wypuszcza nowe klatki. Otrzymujemy płynny pozbawiony Tearingu obraz. Problemy zaczynają się jeśli karta nie jest w stanie generować tylu klatek. W takiej sytuacji, mechanizm synchronizacji obniży limit do jednego z dzielników maksymalnej częstotliwości odświeżania, czyli w przypadku 60Hz będzie dt 30, 20 czy np. 15Hz. Każde przejście na niższą częstotliwość jak i powrót mogą i najczęściej spowodują pojawienie się Stutteringu (Przycięć).

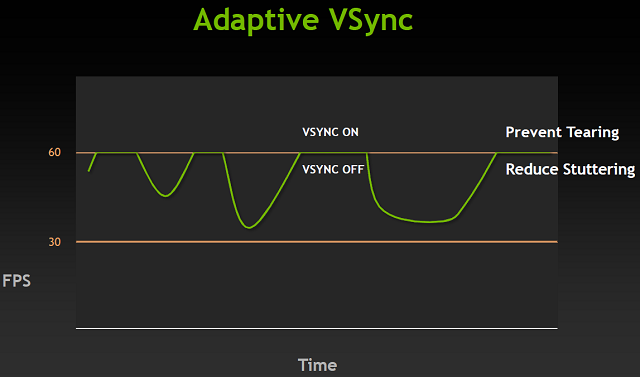

Po raz kolejny z pomocą przychodzi nam nowe rozwiązanie NVIDII - adaptacyjna synchronizacja pionowa. W przypadku gdy nasze GPU nie jest w stanie renderować wystarczająco dużej liczby klatek, aby synchronizacja działała na częstotliwości odświeżania monitora, zamiast przechodzić do dzielników zostaje po prostu wyłączona. Takie podejście do sprawy likwiduje poszarpany obraz związany z wyższym niż odświeżanie FPS, a także eliminuje przycięcia związane z przechodzeniem na niższe poziomy synchronizacji. Nie jest to jednak rozwiązanie idealne, ponieważ efekt poszarpania istnieje także w sytuacji, gdy liczba generowanych klatek jest mniejsza od częstotliwości odświeżania. Aczkolwiek efekt ten jest znacznie mniej widoczny niż oba likwidowane przez nowe rozwiązanie. Adaptive VSync działa programowo wchodząc wraz z nowymi sterownikami R300 i będzie obsługiwane również przez starsze karty.

FXAA w sterownikach

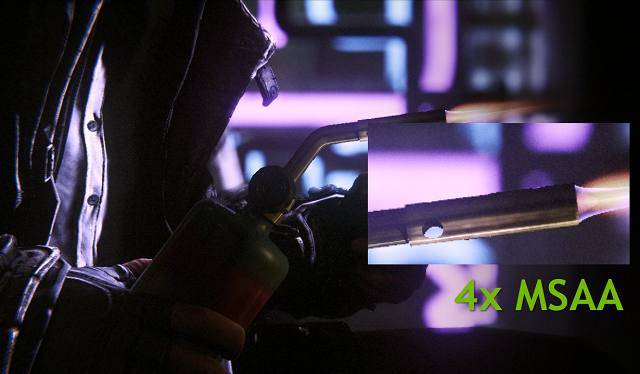

Wraz z nowymi sterownikami R300 towarzyszącymi premierze GeForce GTX 680, NVIDIA wprowadza także możliwość wymuszani FXAA poprzez panel kontrolny sterowników. Dotychczas jedyną możliwością korzystania z tego trybu wygładzania krawędzi, była aktywacja we wspierającej go grze, albo wykorzystanie specjalnych programów wstrzykujących stosowny kod (np. FXAA Injector). Popularność FXAA jako podstawowego trybu AA wśród deweloperów stale rośnie, ponieważ FXAA zapewnia nawet dwukrotnie więcej FPS niż 4xMSAA, oferując zbliżony wizualnie obraz. W przeciwieństwie do MSAA, FXAA jest jednak wykorzystane na etapie post procesingu razem z blurem czy bloomem.

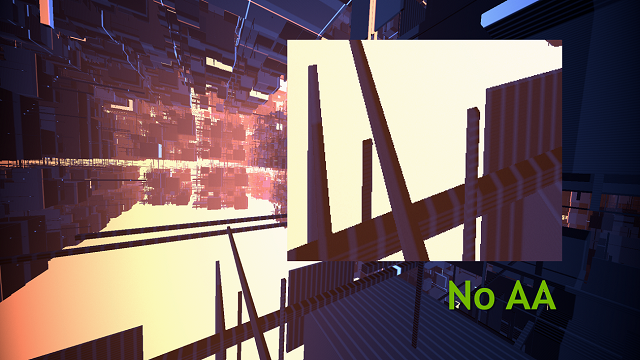

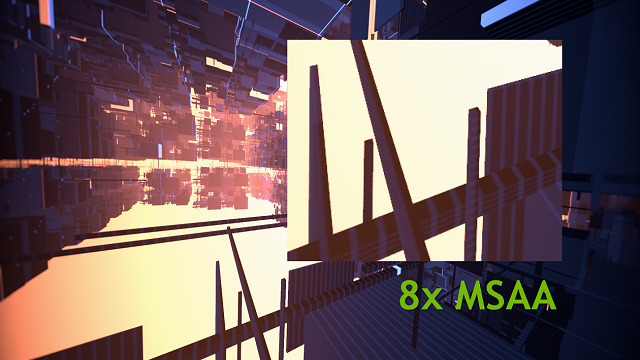

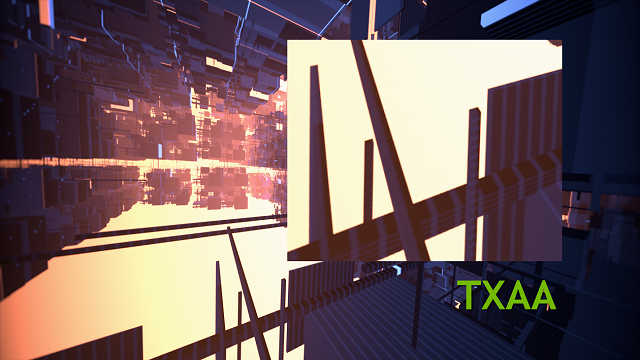

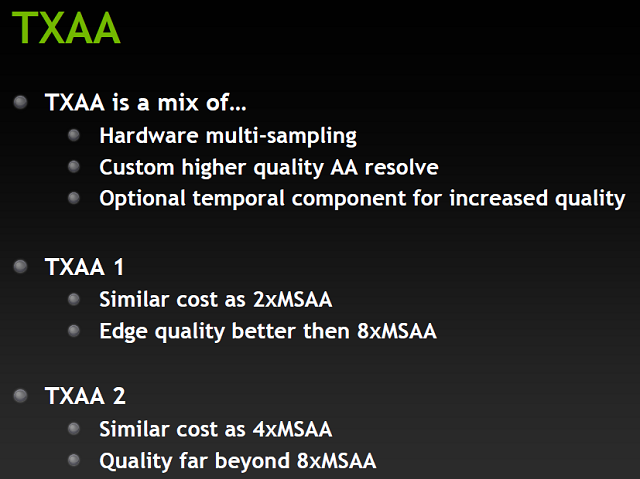

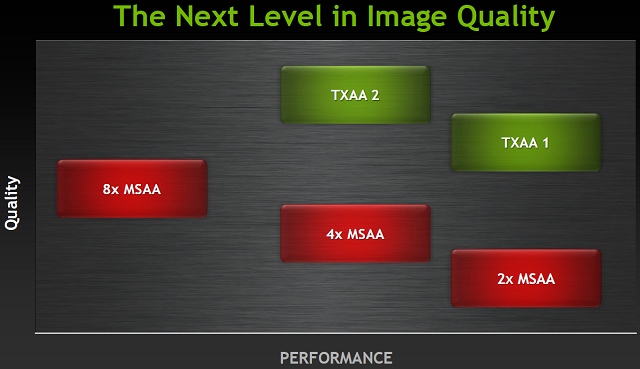

TXAA - nowe metoda AA

Wraz z Keplerem debiutuje też nowy tryb wygładzania krawędzi. TXAA ma wykorzystywać znacznie większą wydajność nowych GeForców w dziedzinie obróbki tekstur FP16. Nowe wygładzanie będzie mieszanką sprzętowego AA, podejścia do AA w stylu filmów CG, oraz w przypadku trybu 2xTXAA dodatkowego opcjonalnego elementu czasowego. Znaczna część algorytmu TXAA to wysokiej jakości filtr starannie zaprojektowany z myślą o współpracy z post procesowym potokiem zgodnym z HDR. Od strony jakościowej i wykorzystania zasobów GPU, TXAA ma oferować jakość porównywalną z 8xMSAA obciążając kartę jak 2xMSAA. Wyższy tryb 2xTXAA będzie obciążać system jak 4xMSAA oferując jednak lepszą od 8xMSAA jakość obrazu. TXAA ma być wspierane przed nadchodzące tytuły takie jak MechWarrior Online, Borderlands 2, czy silnik Unreal 4.

NVENC - Sprzętowy enkoder H.264

Ostatnią z nowości wprowadzaną w samym rdzeniu Keplera jest sprzętowy enkoder H.264. W poprzednich generacjach kart NVIDII kodowaniem i dekodowaniem materiału wideo zajmował się programowy enkoder wykorzystujący do pracy procesory CUDA. O ile rozwiązanie takie jest znacząco szybsze niż wykorzystywanie do obliczeń CPU, to posiada ono istotną wadę - spore zużycie energii. Tak jak cała architektura Keplera, tak i NVENC podyktowany jest względami wydajności z jednego wata. Nowy sprzętowy enkoder jest blisko 4-krotnie szybszy od starszych bazujących na CUDA programowych rozwiązań, jednocześnie konsumując znacznie mniej prądu.

Enkoder NVENC to:

- Nawet 8-krotnie szybsze od czasu rzeczywistego kodowanie materiału full HD (1080p). Przykładowo: kodowanie 16 minutowego 30 FPS klipu 1080p z wykorzystaniem wysokiego profilu wydajności zajmie w przybliżeniu 2 minuty.

- Wsparcie dla profili H.264: bazowego, głównego i wysokiego, oraz poziomu 4.1 (Standard Blu-ray)

- Wsparcie dla MVC (Multiview Video Coding) - kodowania stereoskopowego będącego rozszerzeniem H.264 wykorzystywanym przy 3D Blu-ray.

- Wsparcie dla kodowania w rozdzielczości aż do 4096x4096.

Warto wspomnieć, że NVENC może być wykorzystywany równolegle do klasycznego programowego enkodera. Pozwala to na kodowanie dwóch materiałów na raz, jednakże algorytmy wstępnego przetwarzania NVENC mogą wymagać użycia rdzeni CUDA tym samym ograniczając ewentualnie wydajność programowego CUDA kodera.

- « pierwsza

- ‹ poprzednia

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- …

- następna ›

- ostatnia »

- SPIS TREŚCI -

- 0 - Silni, zwarci i gotowi na przybycie tytana?

- 1 - NVIDIA GeForce GTX Titan - Budowa

- 2 - NVIDIA Kepler - Opis architektury #1

- 3 - NVIDIA Kepler - Opis architektury #2

- 4 - Platforma testowa i metodologia pomiarowa

- 5 - Testy: 3DMark 11

- 6 - Testy: Heaven Benchmark

- 7 - Testy: Stone Giant

- 8 - Testy: Aliens vs Predator

- 9 - Testy: Battlefield 3

- 10 - Testy: Crysis: Warhead

- 11 - Testy: Crysis 2

- 12 - Testy: DiRT 3

- 13 - Testy: Mafia II

- 14 - Testy: Metro 2033

- 15 - Testy: Stalker: Call of Pripyat

- 16 - Testy: The Elder Scrolls V: Skyrim

- 17 - Testy: Wiedźmin 2: Zabójcy Królów

- 18 - Testy: Hitman: Absolution

- 19 - Testy: Far Cry 3

- 20 - Testy: 5760x1080

- 21 - Podkręcanie: 3DMark 11 / Crysis 2 / Skyrim / AvP / Battlefield 3 / Wiedźmin 2

- 22 - Temperatury i system chłodzenia

- 23 - Pobór mocy: spoczynek / obciążenie / OC

- 24 - Podsumowanie: komu GTX Titan przypadnie do gustu?

Powiązane publikacje

Test komputera do grania Actina PBM - Intel Core i5-14600KF i NVIDIA GeForce RTX 4070 Ti SUPER to wydajne połączenie

44

Test karty graficznej ASUS GeForce RTX 4070 Ti Super TUF Gaming - Jeden z najlepszych modeli niereferencyjnych

54

Test Horizon Forbidden West PC - Porównanie jakości technik skalowania NVIDIA DLSS, AMD FSR oraz Intel XeSS

34

Test wydajności kart graficznych Horizon Forbidden West PC - Ładna grafika i rozsądne wymagania sprzętowe? Niemożliwe...

156